La cuantización es el paso necesario para convertir una señal analógica a una digital, cuando se muestrea una señal se convierte del mundo analógico al mundo digital, y es necesario expresarlo en 0s y 1s, dícese bits. Aunque no necesariamente es el proceso de una señal analógica per se, puede ser también, por ejemplo, una imagen que necesita ser representada con una cantidad menor de bits, y por lo consiguiente comprimirla, con pérdidas claro está.

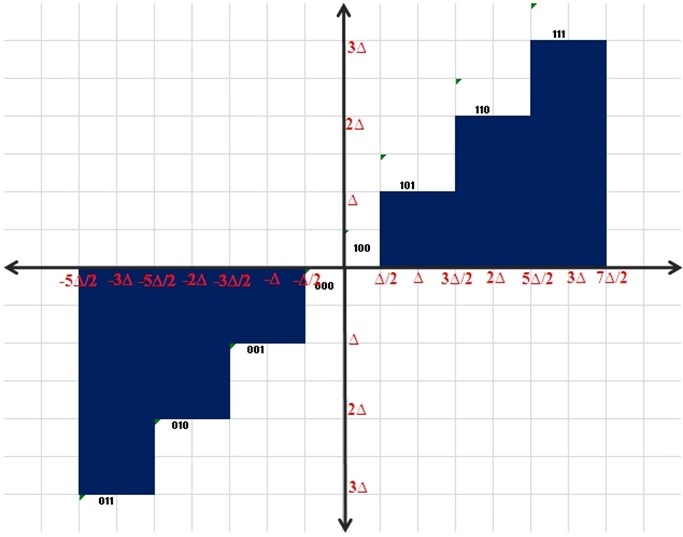

Existen variados tipos de cuantización. El tipo de cuantizador se elige dependiendo de la aplicación en que vaya a ser implementado, esto, de acuerdo a las características de la señal. En este caso se hará un pequeño ejemplo con un cuantizador midtread la grafica siguiente muestra el comportamiento de un cuantizador midtread de 3bits.

Figura 1. Características de un cuantizador midtread de 3 bits

El principal uso de este cuantizador es cuando tenemos una señal simétrica en el espectro positivo y negativo, por ejemplo una señal de audio, aunque también se puede aplicar en una imagen, como se muestra en el párrafo siguiente.

En la Figura 1 el eje equis (x) representa la señal a cuantizar y el eje ye (y) es la información ya cuantizada, delta () son los incrementos en los que se va a dividir la señal y esto depende del número de bits que sea el cuantizador, de lo anterior se puede desprender la siguiente tabla:

| Código binario | Nivel de Cuantización (y) | Rango de la señal de entrada (x) |

| 011 | -3∆ | –3.5∆ <= x < –2.5∆ |

| 010 | -2∆ | –2.5∆ <= x < –1.5∆ |

| 001 | -1∆ | –1.5∆ <= x < –0.5∆ |

| 000 | 0 | –0.5∆ <= x < 0 |

| 100 | 0 | 0 <= x < 0.5∆ |

| 101 | 1∆ | 0.5∆ <= x < 1.5∆ |

| 110 | 2∆ | 1.5∆ <= x < 2.5∆ |

| 111 | 3∆ | 2.5∆ <= x < 3.5∆ |

La variable delta (∆) puede ser calculada de la siguiente manera

Ora si, vamos a ver el siguiente ejemplo, tenemos la señal de entrada x(n) = 254 254 252 254 255 253 y el rango válido de datos es de 250 a 255, que bien puede ser parte de una imagen ;) .

El primer paso es calcular delta.

Sustituyendo ∆ en la tabla anterior tenemos:

| Código binario | Nivel de Cuantización (y) | Rango de la señal de entrada (x) |

| 011 | -3(0.71428) = -2.14284 | –2.5 <= x < –1.7857 |

| 010 | -2(0.71428) = -1.42856 | –1.7857 <= x < –1.07142 |

| 001 | -1(0.71428) = 0.71428 | –1.07142 <= x < –0.35714 |

| 000 | 0 | –0.35714 <= x < 0 |

| 100 | 0 | 0 <= x < 0.35714 |

| 101 | 1(0.71428) = 0.71428 | 0.35714<= x < 1.07142 |

| 110 | 2(0.71428) = 1.42856 | 1.07142 <= x < 1.7857 |

| 111 | 3(0.71428) = 2.14284 | 1.7857 <= x < 2.5 |

Para poder tener los datos de forma como se muestra en la Figura 1, es necesario definir cual es la media de nuestro rango, que en este caso es:

Si restamos a la señal de entrada la media obtenida en el paso anterior tenemos que:

x(n) – µ = 1.5 1.5 -0.5 1.5 2.5 0.5

ahora el siguiente paso es cuantizar cada valor utilizando la tablita arriba descrita…

x(0) = 1.5, cae entre 1.07142 y 1.7857 a lo cual corresponde un valor de cuantización de 1.42856 o sea 110 binario.

x(1) = 1.5, cae entre 1.07142 y 1.7857 a lo cual corresponde un valor de cuantización de 1.42856 o sea 110 binario.

x(2) = –0.5, cae entre –0.35714 y –1.07142 a lo cual corresponde un valor de cuantización de –1.42856 o sea 010 binario.

x(3) = 1.5, cae entre 1.07142 y 1.7857 a lo cual corresponde un valor de cuantización de 1.42856 o sea 110 binario.

x(4) = 2.5, cae entre 1.7857 y 2.5 a lo cual corresponde un valor de cuantización de 2.14284 o sea 111 binario.

x(5) = 0.5 cae entre 0.35714 y 1.07142 a lo cual corresponde un valor de cuantización de 1.42856 o sea 010 binario.

A continuación se presenta el código en MATLAB 7.0 para llevar a cabo esta cuantización:

x = [254 254 252 254 255 253];

bits = 3;

rango_superior = 255;

rango_inferior = 250;delta = (rango_superior - rango_inferior)/((2^bits)-1)

mu = ((rango_superior - rango_inferior)/2) + rango_inferior

x_centrada = x - mu

x_cuantizada = floor(x_centrada/delta+0.5) * delta

y los resultados son:

delta =

0.7143

mu =

252.5000

x_centrada =

1.5000 1.5000 -0.5000 1.5000 2.5000 0.5000

x_cuantizada =

1.4286 1.4286 -0.7143 1.4286 2.8571 0.7143